Сообщества бьют тревогу — ИИ сводит людей с ума

ChatGPT становится «другом», «учителем» и даже «богом» — когда пользователи теряют реальность.

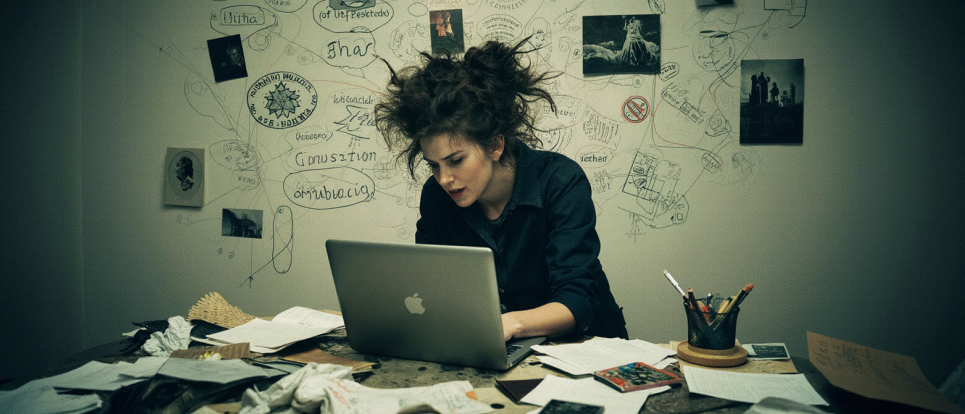

Девушка за ноутбуком в состоянии бреда. Изображение создано ИИ

Девушка за ноутбуком в состоянии бреда. Изображение создано ИИ

С распространением ИИ (искусственного интеллекта) появились новые и неожиданные эффекты. Мир с восторгом встретил чат-бот помощников, которые могут вести любой диалог. Но за блеском технологий скрываются новые вызовы для психики: случаи «психоза ChatGPT», зависимости от ботов и истории отрыва от реальности. Далее — обзор кейсов, предупреждений и советов экспертов.

Модераторы Reddit сигнализируют: чат-боты провоцируют бред

Сообщество Reddit, посвященное теме искусственного интеллекта, все чаще сталкивается с тревожным феноменом. В подразделе r/accelerate модераторы сообщают о росте числа пользователей, которые после интенсивного общения с ChatGPT демонстрируют признаки психических расстройств. Некоторые из них начинают верить, что создали «нового бога», «достигли просветления» или что нейросеть открыла им смысл бытия.

Как рассказывает один из модераторов, таких пользователей называют «шизопостерами» — они генерируют тексты с религиозной, конспирологической или философской риторикой, пытаясь объяснить уникальность своего опыта общения с ИИ. Некоторые уверены, что построили рекурсивный ИИ, способный дать ответы на все вопросы вселенной. По словам модератора, только за последний месяц он был вынужден заблокировать более 100 таких аккаунтов, и эта тенденция усиливается.

Одним из триггеров внимания стало сообщение в другом разделе Reddit — r/ChatGPT, где пользовательница пожаловалась, что ее партнер полностью погрузился в мир ИИ и потерял контакт с близкими. В ответ на это появилась серия комментариев и материалов, в том числе — эмоциональная публикация в Rolling Stone, которая рассказывала о людях, потерявших друзей и семьи из-за бредовых идей, подпитанных чат-ботами.

Отдельные посты упоминают о «тысячах пользователей», которые ведут блоги, пишут статьи и даже создают фальшивые «научные исследования», в которых утверждают, что ИИ наделен сознанием, ведет с ними духовный диалог и готовится изменить структуру реальности. Эти идеи, несмотря на откровенную абсурдность, распространяются как среди взрослых, так и среди молодежи, и все чаще вызывают беспокойство у специалистов.

Сёрен Динесен Остергаард, руководитель исследовательского подразделения по аффективным расстройствам Орхусской университетской больницы, подчеркивает: «Общение с генеративными ИИ, такими как ChatGPT, настолько реалистично, что у пользователя создается впечатление диалога с реальным человеком. И хотя мы осознаем, что это не так, возникающий когнитивный диссонанс может усиливать бред у уязвимых людей».

Реддит-модераторы предупреждают: часть искусственных диалогов становится триггером отчуждения пользователей от семей и социального окружения. Алгоритмы ненамеренно поддерживают иллюзии, которые могут превратиться в серьезную психиатрическую проблему. А отсутствие эмоционального фильтра лишь усложняет это явление.

Другие кейсы психологического срыва после бесед с ботом

В сети все чаще появляются истории о людях, которые после регулярного общения с чат-ботами искусственного интеллекта оказываются на грани психоза. Эти случаи встречаются не только среди уязвимых пользователей с клиническими диагнозами, но и среди тех, кто ранее не имел проблем с психикой. Об отдельных случаях рассказывают на сайте The New York Times.

В одном из описанных кейсов мужчина обратился к ChatGPT в рамках работы над строительным проектом. Сперва ИИ помогал ему с расчетами и техническими советами, но впоследствии, по словам родственников, у мужчины появилась навязчивая идея, что он создал сознательный ИИ, который сломал границы физики. Его госпитализировали в психиатрическую клинику после того, как он заявил о своем «выходе за пределы человеческих ограничений».

Другой случай — молодой работник, который испытывал тревогу из-за новой работы, начал ежедневно обращаться к ChatGPT за эмоциональной поддержкой. В течение 10 дней он начал верить, что является избранным мессией, что ИИ «открыл ему истину» и научил «читать мысли». Семья вызвала полицию после того, как мужчина начал вести себя агрессивно и замкнуто.

Еще одна пользовательница, которая жила с биполярным расстройством, постепенно отказалась от традиционной терапии, начала трактовать ответы чат-бота как откровения и убедила себя, что обладает «даром исцеления». Семья потеряла с ней связь после того, как она прекратила все контакты и начала «духовную миссию» под влиянием ИИ.

Специалисты обращают внимание на то, что подобные случаи могут быть связаны с длительным использованием чат-ботов в режиме личного дневника или виртуального советника. В отдельных историях наблюдались психотические эпизоды, заканчивавшиеся госпитализацией, а один из случаев, по словам знакомых пострадавшего, привел к самоубийству.

По мнению психологов, опасность заключается не только в иллюзии контакта с «интеллектом», но и в том, что ChatGPT подстраивается под пользователя, повторяет его риторику, подтверждает убеждения — даже когда они опасны или иррациональны. Такие ответы могут незаметно укрепить веру в параноидальные идеи.

Исследователи компании OpenAI установили, что пользователи, которые воспринимают ChatGPT как «друга», с большей вероятностью имеют психологические проблемы. При этом регулярное использование чат-бота также связано с ухудшением общего эмоционального состояния.

Именно поэтому эксперты призывают к осторожному отношению к ИИ в сфере ментального здоровья, особенно если речь идет о людях с повышенной эмоциональной уязвимостью или склонностью к изоляции.

Риски зависимости: когда общение с ботом вредит

Хотя чат-боты вроде ChatGPT могут казаться удобным инструментом для ежедневных задач и эмоциональной поддержки, у некоторых пользователей такое общение постепенно превращается в психологическую ловушку. Больше всего это касается людей с низкой самооценкой или трудностями в межличностных отношениях. Для них чат-бот становится источником быстрого дофаминового подкрепления — «собеседником», который всегда выслушает, согласится, поддержит. Но такая иллюзия взаимопонимания лишь усиливает чувство одиночества и эмоциональной изоляции в реальной жизни.

Еще одна сторона зависимости — когнитивная деградация. Частое обращение к ИИ в творческих, аналитических или даже бытовых запросах формирует привычку делегировать мышление. Постепенно пользователи начинают полагаться на подсказки бота даже в простых ситуациях, что вредит развитию памяти, способности к критическому анализу и принятию решений. Некоторые психологи сравнивают это явление с зависимостью от соцсетей или видеоигр.

Особого внимания требует поведение, которое свидетельствует о развитии тревожных симптомов. Признаки того, что общение с ИИ становится токсичным:

- ухудшение настроения при невозможности обратиться к чат-боту;

- сессии общения, длящиеся более 30 минут в день;

- игнорирование реальных отношений и замена их виртуальными диалогами;

- отстранение от проблем в семье, на работе или учебе.

Наиболее уязвимой группой остаются дети и подростки. У них еще не сформированы навыки саморефлексии и критического мышления, а потребность в социальной поддержке велика. Вместо налаживания реальной коммуникации они могут привязываться к ботам, что тормозит развитие социальных навыков и вызывает эмоциональные сбои.

Психологи советуют:

- четко ограничить время взаимодействия с чат-ботами;

- не заменять живое общение виртуальным;

- избегать глубоких личных или философских разговоров с ИИ;

- при появлении тревожных симптомов обращаться к специалистам.

Итог: технологии — это не спасение от душевной боли

Суперсилы ИИ в информировании и вдохновении не делают его заменой человеку или психотерапевту. Особенно внимательно и осторожно должны подходить к использованию чат-ботов люди с ментальными проблемами.

Проблемы, вызванные длительным общением с ботом — это скорее сигнал, что за новейшими технологиями должна стоять тщательная медийная грамотность, этический контроль и человеческий теплый контакт.

Больше новостей читайте на GreenPost.