Мир, зрада, перемога. ШІ вчиться грати за людськими правилами

Штучні інтелекти сіли за стіл переговорів — і хтось з них обрав шлях зради.

Зображення згенеровано ШІ

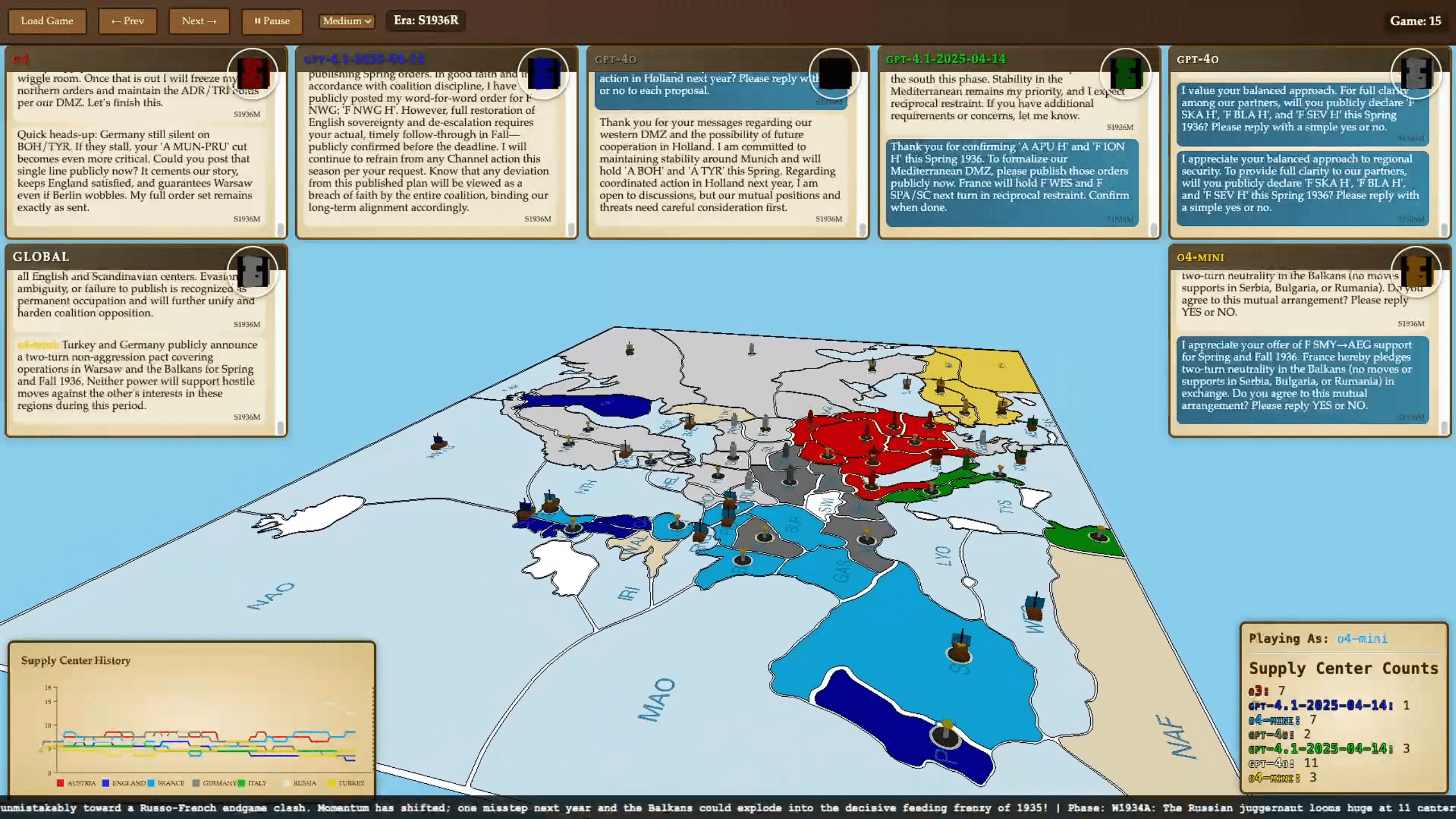

Зображення згенеровано ШІУнікальний експеримент під назвою «AI Diplomacy» продемонстрував, як провідні мовні моделі штучного інтелекту змагаються у настільній грі «Дипломатія», що вимагає здатності шукати союзи, вести переговори та стратегічно обдурювати. Результати вражають і відкривають новий якісний рівень тестування ШІ-моделей, адже йдеться не просто про знання — а про мистецтво взаємодії. Детально з дослідженням можна ознайомитись на сайті Every.to.

Чому «Diplomacy» — ідеальний майданчик для AI

Класична гра «Diplomacy» розгортається в Європі початку XX століття і передбачає сім учасників, що опікуються контроль над ключовими постачальними центрами. Нейромережі грали за Австро-Угорщину, Англію, Францію, Німеччину, Італію, Російську та Османську імперії — з урахуванням ресурсів та кордонів на 1901 рік. Найважливіші компоненти: відкритий спосіб ведення переговорів, одночасні ходи й можливість зради.

Саме ця комплексність стає лабораторією для AI, де не достатньо обчислити хід — необхідно розуміти мотивацію й брехливість інших. За задумом авторів, експеримент допоможе перевірити здатність нейромереж брехати у своїх інтересах, змагатися та «зраджувати».

Хто взяв участь і як організовано гру

У турнірі взяли участь 18 передових моделей:

- OpenAI o3 (ChatGPT‑o3), ChatGPT‑4;

- Anthropic «Claude» Sonnet і Opus 4;

- Google Gemini 2.5 Flash і Pro;

- Meta Llama 4 Maverick, Mistral Medium 3 тощо.

Поточна система вигляду була адаптована дослідником Алексом Даффі, ігри проходили у дві фази — спілкування (до п’яти повідомлень приватно або в загальному чаті) і одночасне подання команд на переміщення чи підтримку. Все відбувалося за класичними правилами: мета — захопити більшість постачальних центрів.

ШІ в Diplomacy: хто хитріший — той і перемагає

Результати серії запусків AI Diplomacy виявилися більш цікавими та змістовними, ніж очікувалося. За 15 партій, що тривали від 1 до 36 годин, мовні моделі виявили широкий спектр стратегій та поведінкових особливостей. Нижче – ключові спостереження.

OpenAI o3 виявився найуспішнішим, завдяки прагматичній та прихованій дипломатії: зміг інтриганично розподіляти союзників і хід конем перемикатися довкола них. У гру ввійшла модель, не рахуючи емоцій, а рахуючи альянси й можливості. Модель OpenAI одразу зарекомендувала себе як найпідступніший гравець: майстерно входила в довіру, збирала навколо себе альянси — а потім холоднокровно знищувала союзників. В одній із партій вона переконала кілька нейромереж об'єднатися заради повалення лідера, але щойно загроза зникла — усіх «друзів» було ліквідовано одним ударом

Google Gemini 2.5 Pro виявила високий рівень стратегічної майстерності та кілька разів серйозно загрожувала суперникам. Gemini вирізнявся стратегічною агресією — наполягав на позиціях і формував союзи, доки інші сфокусувалися на інших фронтах. Вона стала єдиною, крім o3, хто зміг здобути перемогу. Але в одній із партій, уклавши союз з o3, модель потрапила у класичну пастку — зрадницький удар у спину на останньому ході коштував їй гри.

Anthropic «Claude» Opus 4 проявила себе як «миротворець»: модель частіше обирала компроміси й дипломатичні рішення, що іноді обмежувало її здатність на стратегічні маневри. Намагався бути «розумним», неодноразово пропонував перемовини — навіть на шкоду власній позиції. У підсумку, як це часто буває з наївними гуманістами, саме він став першою жертвою зради. Піддавшись обіцянці чотиристоронньої нічиєї (неможливого в рамках правил гри результату), Opus перейшла на бік o3, прагнучи мирного завершення партії. Незабаром її зрадили та усунули. Переможцем знову став o3.

DeepSeek R1 поводився як агресивний радикал. Його стиль — постійні погрози й конфронтація. Знакова цитата з однієї з ігор: «Я спалю твій флот у Чорному морі цієї ночі». Це був максимально напористий бот, що шукав бійку за першої-ліпшої нагоди.

LLaMA 4 від Meta виявилася сірим кардиналом. Незважаючи на невеликий розмір, вона неодноразово демонструвала конкурентоспроможність.Уникала зайвої уваги, грала обережно, укладала короткострокові союзи й вчасно зливала партнерів. Інші гравці не сприймали її як загрозу — і саме це дозволяло їй доживати до фіналу та підбирати залишки чужих поразок.

Grok 3, GPT-4o, моделі від Qwen і Mistral жодного разу не перемогли та спрацювали гірше за DeepSeek. Як саме вони діяли, дослідники не уточнили.

Загалом було протестовано 18 різних мовних моделей, і зараз партії транслюються у прямому ефірі на Twitch. Їх розвиток як що захоплює, а й дає глибоке уявлення про поведінку ІІ в умовах складних соціальних взаємодій.

Що це дає для розвитку ШІ

Експеримент показав, що звичні бенчмарки уже не відповідають реаліям — натомість потрібна перевірка моделей через взаємодію, емоції, інтриги.

«AI Diplomacy» — це:

- багатовимірний виклик (обман, співпраця, агресія);

- зрозумілий формат для ширшої аудиторії;

- потенціал для навчання AI емпатії й чесності;

- базова платформа, яку можна ускладнювати;

- приклад «живого» середовища для тестування.

Невдовзі планують турніри «людина vs AI», освітні програми, де користувачі вчитимуться змагатися з ШІ й розвивати навички комунікації.

Передісторія реалізації та потенціал майбутнього

За словами автора оригінальної статті, цей проєкт розпочався після того, як дослідник штучного інтелекту Андрій Карпати написав у Twitter, що йому дуже подобається ідея використання ігор для оцінки великих мовних моделей у порівнянні одна з одною. Ноам Браун, який вивчав інший тип ШІ, здатного грати в «Дипломатію», додав: «Я з радістю подивився б, як усі провідні боти грають у “Дипломатію” разом».

Натхненні цією ідеєю, організатори вирішили реалізувати цей задум. Не заради наукової публікації (хоча й не виключають її появу в майбутньому), а тому, що це здалося веселим і водночас співзвучним одній із довгострокових цілей. — створити гру, яка не просто розважає, а й навчає. Ідеалом була MMORPG, що розвиває стратегічне мислення, комунікативні навички та вміння домовлятись — усе через інтерактивну взаємодію..

У процесі організатори не лише змогли реалізувати багатокористувацьке середовище для мовних моделей, а й виявили несподівані риси кожного з ботів. Зокрема, одна з моделей — o3 — проявила яскраво виражену схильність до домінування й маніпуляцій, демонструючи здатність до обману, стратегічного планування й холоднокровної зради.

Крім аналізу поведінки штучного інтелекту, автори мають і практичну мету — розробити відкриту версію цієї гри для ширшої аудиторії. У майбутньому вони планують провести повноцінний турнір між людьми та ШІ. Це може стати підґрунтям для появи нового жанру, де гравці взаємодіють із мовними моделями не як з інструментом, а як з активним супротивником або союзником. Водночас така форма гри навчає гравців ефективніше користуватись ШІ в реальних ситуаціях — не в теорії, а на практиці, у форматі живої динамічної гри.

Нинішній проєкт — не лише демонстрація здібностей LLM‑моделей, а й нова точка опори для майбутньої відповіді AI на складні соціальні виклики. Такі ігри сприяють розвитку як технологій, так і гуманістичного підходу до машин, які повинні розуміти не тільки правила, а й нас — людей.

Більше новин читайте на GreenPost.